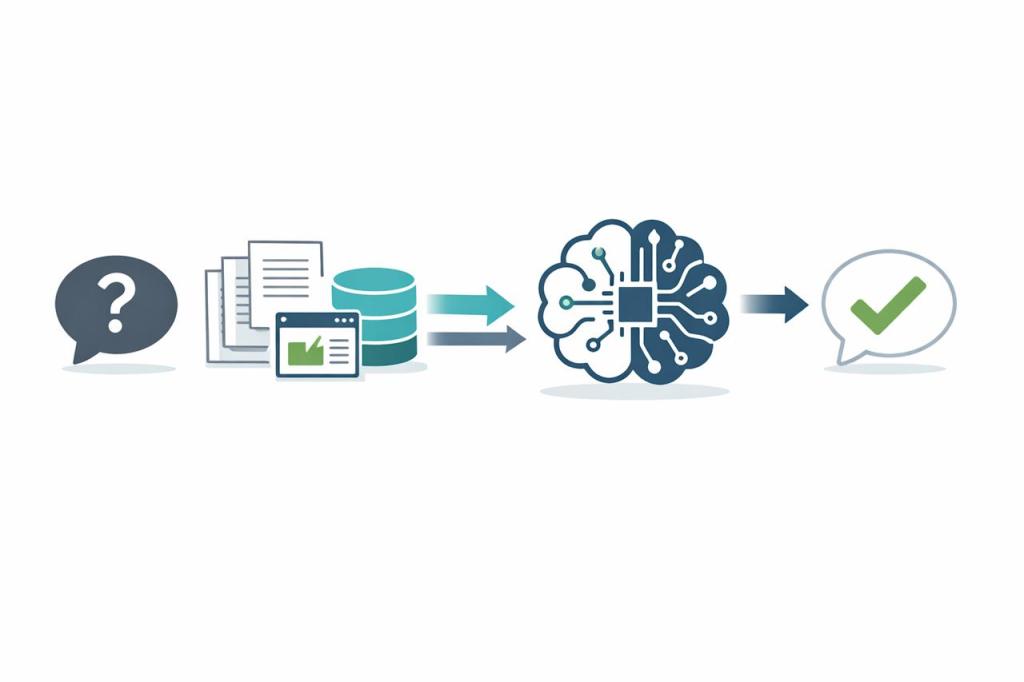

Er gaat soms het gerucht dat ChatGPT “het hele internet” heeft binnengehaald als trainingsdata. Dat is niet juist. Zelfs op televisie wordt deze foutieve informatie soms gedeeld, zelfs door mensen die als experts worden gepresenteerd. In deze blog leg ik uit hoe OpenAI de data voor hun modellen eigenlijk verzamelt en waarom een volledige webcrawl niet haalbaar of wenselijk is.

1. Gericht gebruik van Common Crawl

OpenAI maakt gebruik van periodieke dumps van Common Crawl, een openbare verzameling webpagina’s. Die data is weliswaar omvangrijk, maar wordt eerst grondig gefilterd op duplicaten, spam en lage‑kwaliteit content. Daardoor blijft alleen de meest waardevolle tekst over. Het is daarbij belangrijk om te weten dat privéplatforms zoals Facebook of Instagram daar niet zomaar tussen zitten. Als je vandaag iets op je Facebookpagina zet, kun je er dus gerust op zijn dat het morgen niet ineens in ChatGPT zit. Zulke data wordt niet zomaar verzameld of gebruikt, zeker niet als het achter een login of in besloten kring staat.

2. Specifieke aanvullende datasets

Naast Common Crawl vult OpenAI de trainingscorpora aan met zorgvuldig geselecteerde bronnen, zoals:

- WebText, een dataset gebaseerd op Reddit‑gelinkte artikelen

- Boekencollecties, zowel fictie als non‑fictie

- Wikipedia, dumps in meerdere talen

- Wetenschappelijke artikelen (bijvoorbeeld arXiv‑preprints)

- Nieuwsarchieven en gelicenseerde datasets

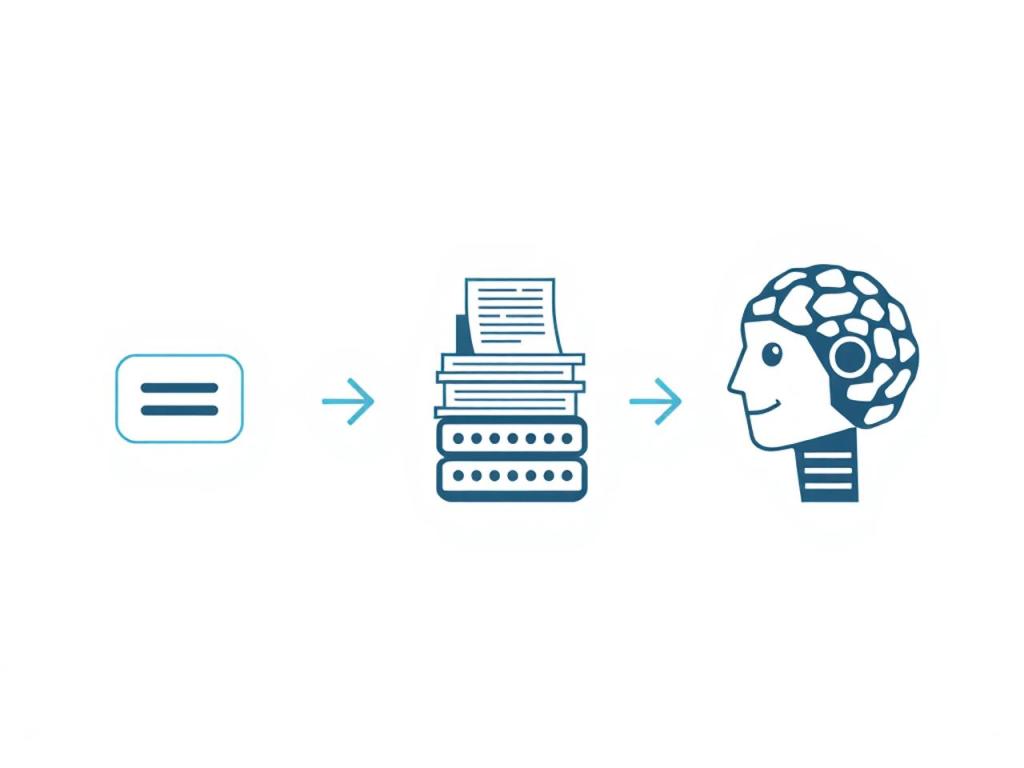

3. Kwaliteits‑ en privacy‑overwegingen

Een complete webcrawl bevat veel ruis: webpagina’s met weinig tekst, herhalingen, of inhoud die auteursrechtelijk niet vrij is. Door alleen bronnen te kiezen die publiek beschikbaar of gelicenseerd zijn, blijft de dataset zowel kwalitatief hoogwaardig als juridisch correct. ChatGPT past, naast duplicaat‑ en spamfiltering, de volgende kwaliteitschecks toe:

Taal en structuur

- Alleen webpagina’s in ondersteunde talen blijven over, zodat zinnen in vreemde of onbekende talen eruit gaan

- HTML- en andere opmaakcode (de ‘bouwtekening’ achter een website) worden verwijderd, zodat er alleen schone tekst overblijft

Inhoud en broncontrole

- Pagina’s met heel weinig tekst of veel herhalende standaardtekst (ook wel boilerplate genoemd, bijvoorbeeld menu’s of advertentieteksten) worden geweerd

- Content die niet publiek beschikbaar is of beschermd wordt door auteursrecht blijft buiten de selectie, tenzij daar een licentie voor is

Informatiewaarde

- Teksten met veel herhaalde woorden of weinig echte informatie krijgen een lagere score via lexicale diversiteit (hoeveel verschillende woorden gebruikt worden) en informatiedichtheid (hoeveel nuttige inhoud per tekstdeel)

- Zoeken naar near‑duplicates (bijna‑identieke teksten) om dubbele of bijna‑dubbele bronnen nog eens uit te sluiten

Privacy en veiligheid

- Automatisch verwijderen van persoonsgegevens zoals telefoonnummers, e‑mailadressen en privé‑adressen

- Filteren op haatzaaiende, gewelddadige of anderszins ongewenste content, volgens de richtlijnen van OpenAI

Schadelijke instructies en naleving

- Scannen op content die aanzet tot misdrijven of expliciete instructies geeft

- Uitsluiten van materiaal dat in strijd is met wet‑ en regelgeving of met ethische standaarden (compliance, oftewel het voldoen aan regels)

Op deze manier blijft de trainingsdata zowel relevant en informatief als veilig en juridisch correct.

4. Fijnslijpen met menselijke feedback

Na de ruwe data-selectie volgt een stap waarbij menselijke feedback centraal staat, vaak Reinforcement Learning from Human Feedback (RLHF) genoemd. Hierbij gaat het proces zo:

- Menselijke beoordelaars kijken naar voorbeeldantwoorden:

- Er worden modelantwoorden voorgelegd aan beoordelaars met een lijst criteria, zoals begrijpelijkheid en veiligheid.

- Elk antwoord krijgt een score, bijvoorbeeld “duidelijk”, “nauwkeurig” of “geschikt voor alle doelgroepen”.

- Een beloningsmodel leert van die scores:

- Op basis van de beoordelingen wordt een eenvoudig model getraind dat kan inschatten hoe “goed” een antwoord is.

- Dit beloningsmodel geeft later zelf punten aan nieuwe modelantwoorden.

- Bijsturen van het taalmodel met feedback:

- Het taalmodel past zijn interne instellingen aan om antwoorden te geven die hoger scoren bij het beloningsmodel.

- Hierdoor ontstaat een cyclus: model genereert antwoord, beloningsmodel beoordeelt, model past zich aan.

- Meerdere rondes verbeteren de kwaliteit:

- In steeds nieuwe ronden wordt telkens een nieuwe set voorbeeldantwoorden beoordeeld.

- Na elke ronde wordt het model helderder, inhoudelijker en veiliger in zijn reacties.

Dankzij deze herhaalde feedback en verfijning levert het model heldere, betrouwbare en toegankelijke antwoorden.

Conclusie

ChatGPT heeft niet letterlijk elke webpagina gekopieerd, maar is getraind op een grote, representatieve steekproef van hoogwaardige, openbaar toegankelijke en gelicenseerde teksten. Door slimme filtering en menselijke feedback ontstaat zo een model dat zowel veelzijdig als betrouwbaar is.

Vond je dit artikel nuttig? Laat een reactie achter of deel het met andere geïnteresseerden! Jouw support wordt erg gewaardeerd.

Gerelateerde content

- De playlist ‘ChatGPT: Uitleg, Tips en Toepassingen’ op mijn YouTube kanaal ‘De Wereld Van AI’

- Blog categorie ‘ChatGPT’

- Blog: Hoe werkt ChatGPT? Een simpele uitleg voor beginners

- YouTube Video: Hoe werkt ChatGPT? (Eenvoudig uitgelegd)

- Blog post: De Evolutie van ChatGPT: Van GPT-1 tot GPT-4

- Blog post: 10 Tips om Meer uit ChatGPT te Halen

- Blog post: 7 gratis AI-tools voor tekst, beeld en video

Heb je een vraag of toevoeging? Reageer hieronder.