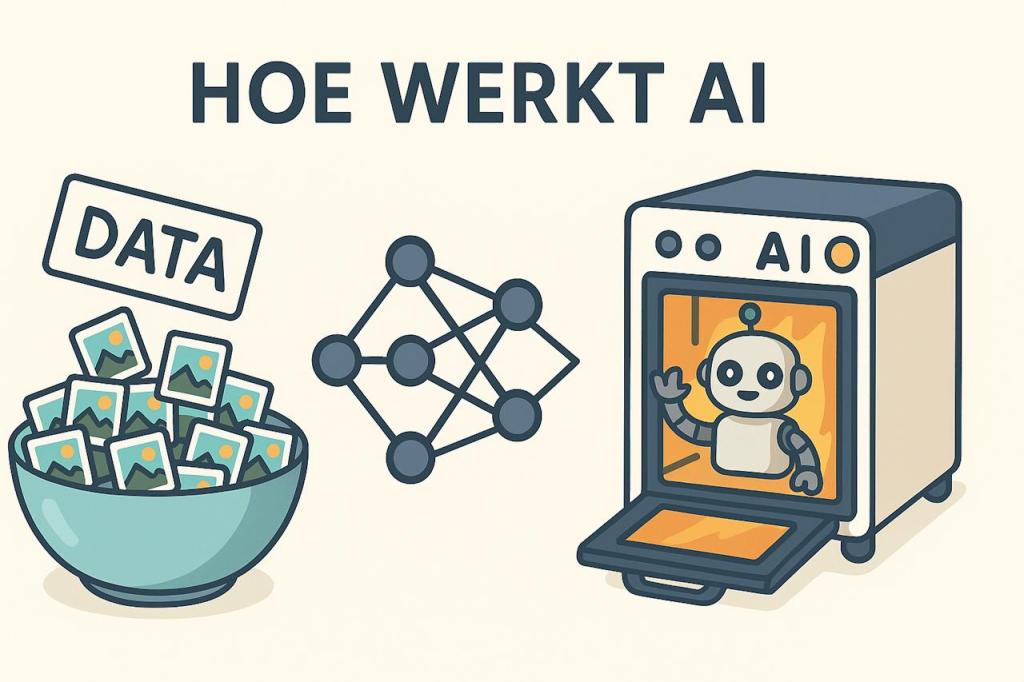

ChatGPT kan schrijven, uitleggen en zelfs redeneren alsof het begrijpt wat je bedoelt. Maar achter die vloeiende zinnen schuilt geen bewustzijn, alleen een enorm slim patroonherkenningssysteem. Hoe leert een taalmodel eigenlijk om woorden te begrijpen en zinnen te vormen die logisch klinken? In dit artikel leg ik uit hoe ChatGPT leert van tekstdata, wat dat precies inhoudt en waarom de kwaliteit van die data zoveel uitmaakt.

Wat betekent leren voor een AI als ChatGPT?

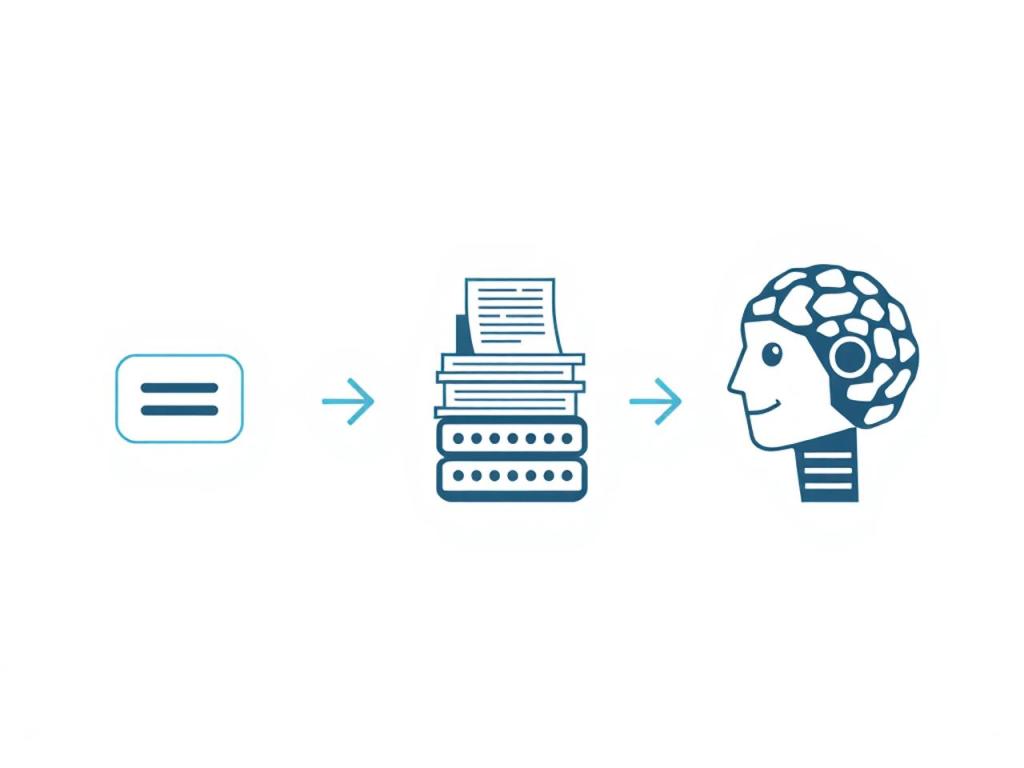

Als mens leer je door te lezen, luisteren en oefenen. ChatGPT leert op een soortgelijke manier, maar dan met enorme hoeveelheden tekstdata. Denk aan boeken, artikelen, websites en gesprekken. Door al die tekst te analyseren, ontdekt het patronen: welke woorden vaak samen voorkomen, hoe zinnen zijn opgebouwd en hoe mensen ideeën uitdrukken. Het doel is niet om te onthouden wat iemand precies schreef, maar om te begrijpen hoe taal werkt.

Heb je je ooit afgevraagd hoeveel tekst er nodig is om een AI taal te laten begrijpen?

Van ruwe tekst naar betekenisvolle patronen

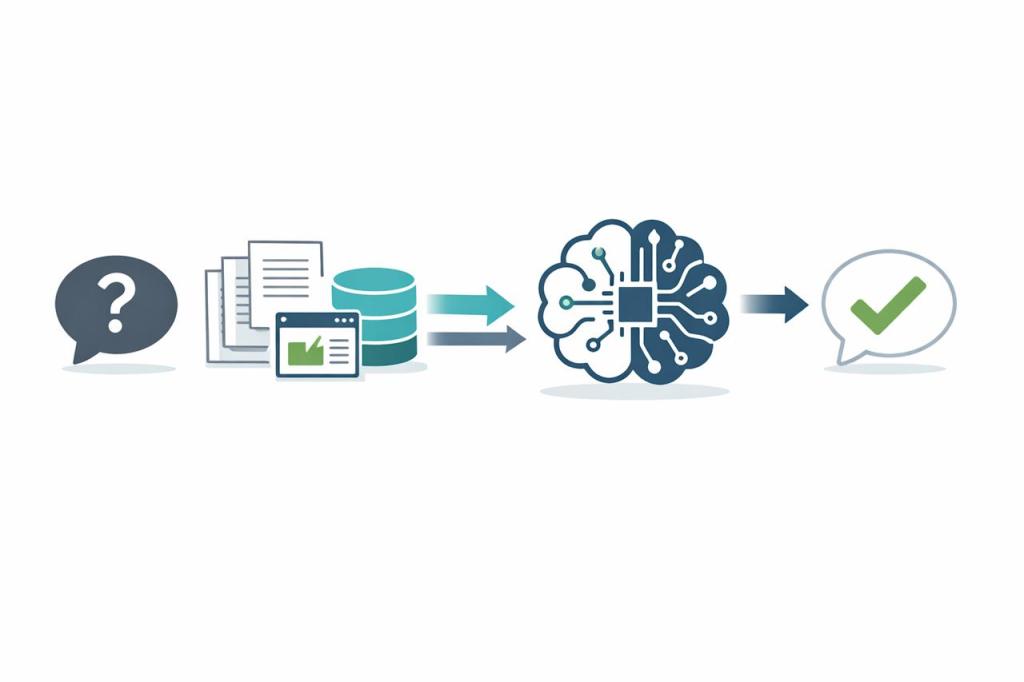

De training van ChatGPT begint met ruwe tekstdata. Die data wordt omgezet in getallen, zogenaamde tokens, die elk een stukje tekst voorstellen. Het model leert hoe deze tokens samen betekenis vormen. Tijdens het trainen voorspelt ChatGPT steeds welk woord waarschijnlijk het volgende is. Als dat klopt, wordt het sterker in die voorspelling. Gaat het mis, dan wordt het model bijgestuurd. Zo leert het stap voor stap taalstructuren herkennen.

Het lijkt een simpel spelletje van raden, maar in werkelijkheid zit er een complex wiskundig netwerk achter dat miljoenen keren per seconde berekeningen uitvoert.

Het belang van kwaliteit in de data

Niet alle tekst is geschikt om van te leren. Daarom wordt de data zorgvuldig geselecteerd. Schrijffouten, haatdragende taal of verkeerde informatie worden eruit gefilterd. Alleen zinnen die helder en correct zijn, blijven over. Daardoor leert ChatGPT beter hoe mensen op een natuurlijke en beleefde manier communiceren.

Hoe denk jij dat de kwaliteit van online teksten de ontwikkeling van AI beïnvloedt?

Wat gebeurt er na de training?

Wanneer het model eenmaal getraind is, leert het niet meer van losse gesprekken. Het gebruikt wat het eerder heeft geleerd om nieuwe antwoorden te vormen. Je zou kunnen zeggen dat ChatGPT een soort “taalinstinct” heeft ontwikkeld. Het begrijpt niet echt de wereld, maar het weet hoe mensen over de wereld praten.

Het blijft dus een systeem dat tekst voorspelt, niet een bewust wezen dat denkt of voelt. Toch maakt die vaardigheid het enorm krachtig voor schrijven, uitleggen en analyseren.

Een balans tussen kennis en voorzichtigheid

Hoewel ChatGPT veel weet over taal, kan het fouten maken of verouderde informatie geven. Daarom is het belangrijk dat mensen kritisch blijven en niet alles klakkeloos aannemen. De samenwerking tussen mens en AI draait om evenwicht: de computer biedt snelheid, de mens voegt inzicht toe.

Hoe gebruik jij AI-tools? Zie je ze vooral als hulpmiddel, of vertrouw je ze al als kennisbron?

Verder leren: bekijk hoe ChatGPT werkt in de praktijk

Nu je weet hoe ChatGPT leert van tekstdata, is het interessant om te zien wat er daarna gebeurt: hoe het model antwoorden vormt op basis van wat het heeft geleerd. In mijn video “Hoe werkt ChatGPT? (EENVOUDIGE uitleg)” laat ik stap voor stap zien hoe een taalmodel van binnen werkt, hoe het voorspellingen doet, en waarom het soms indrukwekkend goed kan klinken — maar ook fouten kan maken.

De video is kort, visueel en makkelijk te volgen, zelfs als je geen technische achtergrond hebt. Zo zie je precies hoe de theorie uit dit artikel tot leven komt.

👉 Bekijk de video hier: Hoe werkt ChatGPT? (EENVOUDIGE uitleg)

Wat vond jij het meest verrassend aan hoe ChatGPT taal begrijpt? Laat het weten in de reacties, ik ben benieuwd naar je mening.

Heb je een vraag of toevoeging? Reageer hieronder.